La settimana della svolta per il futuro dell’«Autopilot» Tesla?

Gli algoritmi del celebre software Full Self-Driving della casa di Elon Musk messi in questione dalla sentenza di un tribunale tedesco e soprattutto dall’addio al progetto del suo paladino: lo scienziato Andrej Karpathy

È stata una settimana interessante quanto a notizie sull’Autopilot, che per Tesla è sia cruccio sia vanto ma soprattutto un pilastro del futuro dell’azienda. Dopo le numerose indagini di authority americane su casi veri o presunti di malfunzionamento, ora anche da questo lato dell’Atlantico Elon Musk ha di che agitarsi al riguardo.

Un tribunale di Monaco di Baviera ha infatti ordinato a Tesla di rimborsare a un cliente tedesco la maggior parte dei €112.000 pagati per un SUV Model X afflitto da problemi alla celeberrima funzione Autopilot, come ha riferito il settimanale Der Spiegel. Un rapporto tecnico ha mostrato che il veicolo non riconosceva in modo affidabile ostacoli come il restringimento di un cantiere e, a volte, scatenava “frenate-fantasma”.

Ciò potrebbe causare un “enorme pericolo” nei centri urbani e portare a collisioni, ha stabilito il tribunale tedesco. Secondo le cronache, i legali Tesla hanno affermato che l’Autopilot non è stato progettato per il traffico urbano; ma secondo la corte non era possibile per i conducenti attivare e disattivare manualmente la funzione con diverse impostazioni, in quanto ciò distrarrebbe dalla guida.

Musk periodicamente afferma che l’Autopilot sta arrivando al traguardo di vera guida che non necessita di intervento umano; ma rinviando al futuro quel momento, Tesla esige che la responsabilità del controllo rimanga in capo a chi è seduto al posto di guida, il che lo rende un apparato di Livello 2 nella tassonomia SAE. Ma l’uomo più ricco del mondo ha anche dichiarato la scorsa primavera che Tesla dovrebbe lanciare una versione beta del software “Full Self-Driving” in Europa entro la fine dell’anno, se ci sarà consenso normativo.

In Germania la legislazione locale consente già la guida di Livello 3 SAE a basse velocità e su strade mappate, con la responsabilità della guida in quei casi sulla casa produttrice in caso di incidente. A complicare le cose però per i produttori di software e sistemi completi per la guida autonoma c’è il fatto che in Europa strade e normative variano molto da paese a paese.

Ma a confermare come la guida autonoma sia un terreno minato, oltre alla mancanza di fretta con cui rivali come Waymo o Cruise la stanno implementando in servizi di robotaxi, c’è lo stress che questo campo comporta anche per i più brillanti scienziati.

In effetti il futuro diventa pieno di nubi, visto che proprio questa settimana Andrej Karpathy (dopo aver annunciato il 27 marzo scorso che si sarebbe preso un periodo di pausa dopo 5 anni di frenetico lavoro come capo della divisione sulla guida autonoma Tesla) ha preso la decisione di passare la mano e lasciare ad altri la responsabilità dell’Autopilot e del software Self-Driving.

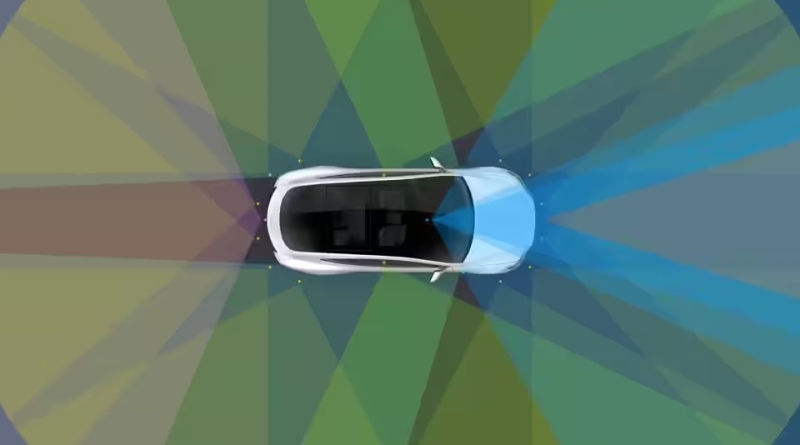

Più in generale, guardando al di là del turnover Tesla che è una costante nella storia dell’azienda, l’uscita di Karpathy crea anche un interrogativo sull’approccio di Musk e dello stesso Karpathy alla guida ad elevata automazione. Infatti Musk non ha mai perso occasione di sostenere che non voleva sensori laser (LiDAR) né il radar sulle sue auto: non solo per risparmiare sui costi, ma per un convinto approccio basato sulla “visione pura”.

Come noto, la maggior parte dei concorrenti e degli scienziati attivi nel settore trovano questo approccio controverso, a causa della palese assenza di ridondanza derivante dal puntare tutte le carte (ed affidarsi) a un singolo sensore.

In un commento per la testata specializzata Synced Kilian Weinberger, professore associato alla Cornell University che lavora sulla visione artificiale per i veicoli autonomi diceva: “le camere sono poco costose rispetto al LiDAR. In questo modo possono mettere questa tecnologia in tutte le auto che stanno vendendo. Se vendono 500.000 auto, tutte queste auto vanno in giro a raccogliere dati per loro”.

In effetti i dati in questo caso diventano il fattore vitale per il successo dei sistemi di apprendimento automatico al centro della tecnologia di guida autonoma. La grande scommessa di Musk e di Karpathy è stata quindi che la montagna di dati video accumulati dalla flotta la aiuterà a raggiungere la piena autonomia più velocemente della minore quantità di dati LiDAR che i suoi concorrenti fanno affidamento su un piccolo numero di auto più provviste di sensori dalle diverse caratteristiche.

Parlando nel 2020 a una conferenza sulla visione artificiale, Karpathy aveva per la prima volta rivelato che dopo anni di lavoro sulle GPU l’azienda aveva costruito un supercomputer, il Dojo, in quel momento il quinto più potente al mondo, per elaborare tutti questi dati.

Aveva anche spiegato la decisione di abbandonare l’ausilio del radar sulle vetture prodotte a Fremont e in Cina, affermando che dopo l’allenamento su oltre 1,5 petabyte di video aumentati sia con i dati radar che con il labeling umano, il sistema di sola visione superava in modo significativo il loro approccio precedente.

Analogamente agli sforzi Tesla, a Cornell Weinberger e collaboratori stanno lavorando per convertire le stime di profondità basate sulle camere nello stesso tipo di nuvole di punti 3D utilizzate dai LiDAR, per migliorarne significativamente la precisione. Karpathy ha rivelato che, dallo stesso periodo dei ricercatori dell’università dell’Ivy League, Tesla stava utilizzando una tecnica “pseudo-lidar” simile.

Gli uni e gli altri si sono scontrati con molti problemi, tuttavia: non solo la percezione della profondità che deve avere accuratezza simile a quella laser, ma anche la tradizionale difficoltà del machine learning a lottare con nuove situazioni.

La logica alla base della raccolta di sempre più dati è che catturerai più dei rari scenari che potrebbero confondere la tua IA, ma c’è un limite fondamentale a questo approccio. “Alla fine hai casi unici. E casi unici per i quali non puoi allenarti”, afferma il professor Weinberger. “I vantaggi dell’aggiunta di un numero sempre maggiore di dati stanno diminuendo ad un certo punto”.

Il tema è tutt’altro che sconosciuto ed ha anzi un nome: “problema della coda lunga”. Secondo Marc Pollefeys, professore al Politecnico di Zurigo che ha lavorato sulla guida autonoma basata sulla visione, rappresenta un ostacolo basilare nel consentire di passare dai comuni sistemi ADAS di assistenza alla guida ai veicoli veramente autonomi (Livello 4 e 5 SAE).

La tecnologia sottostante è simile ma, mentre un sistema di frenata automatico progettato per aumentare le reazioni del guidatore può permettersi di perdere il pedone occasionale, il margine di errore quando si ha il controllo completo dell’auto è di una frazione di punto percentuale. Il che rimanda alla ridondanza scelta da molte aziende di avere più sensori: l’eventualità che tutti commettano lo stesso errore contemporaneamente sono trascurabili.

Cercare di passare da un sistema che funziona a uno che non commette quasi mai errori semplicemente spingendo sempre più dati attraverso in un canale di elaborazione basato sull’apprendimento automatico è destinato a fallire, ritiene Pollefeys. “Quando vediamo che qualcosa funziona il 99 percento delle volte, pensiamo che non può essere troppo difficile farlo funzionare al 100%. E in realtà non è così. Fare 10 volte meno errori è uno sforzo gigantesco”.

L’approccio di Musk e Karpathy, invece, è di segno opposto. E quale sia lo ha sottolineato lo stesso geniale scienziato ormai ex-Tesla, che ha rivelato come sia per lui una bussola l’approccio del collega Rich Sutton, che in questo post del 2019 intitolato “L’amara lezione”, vuol spingere gli scienziati a evitare le idealizzazioni di modelli astratti per dare invece fiducia alla pratica, o meglio allo strumento indispensabile della cassetta degli attrezzi dello specialista di intelligenza artificiale: il calcolo, o più precisamente la crescita della potenza di calcolo.

“La più grande lezione che si può leggere da 70 anni di ricerca sull’IA è che i metodi generali che sfruttano il calcolo sono in definitiva i più efficaci e con un ampio margine, scriveva Sutton. “La ragione ultima di ciò è la legge di Moore, o meglio la sua generalizzazione del costo per unità di calcolo in continua diminuzione esponenzialmente. La maggior parte della ricerca sull’IA è stata condotta come se il calcolo a disposizione dell’agente fosse costante (nel qual caso sfruttare la conoscenza umana sarebbe uno degli unici modi per migliorare le prestazioni) ma, in un tempo leggermente più lungo rispetto a un tipico progetto di ricerca, un numero enorme di calcoli diventa inevitabilmente disponibile”.

Nella ricerca di progressi, ritiene Sutton e con lui Karpathy, i ricercatori cercano di sfruttare esperienza e conoscenza umana di un settore. Rischiando un boomerang, perché “l’unica cosa che conta a lungo termine è lo sfruttamento della computazione”. L’approccio della conoscenza umana tende infatti a complicare secondo l’autore i metodi in modi che li rendono meno adatti a sfruttare i metodi generali che sfruttano il calcolo.

L’uscita di scena di Karpathy dal vertice del reparto di intelligenza artificiale Tesla tuttavia lascia sospettare che la totale fiducia nella potenza di calcolo sia insufficiente ad arrivare all’ambizioso traguardo che anno dopo anno continua a sfuggire all’Autopilot e che ne possa assicurare un brillante futuro.

Qualche indizio sulle ragioni di questo “glorioso fallimento” lo aveva forse identificato con largo anticipo (nel 2019) un altro esperto e imprenditore della tecnologia, Kalev Leetaru, in un denso articolo per la testata Forbes.

Il LiDAR, sosteneva Leetaru, è diventato uno standard di fatto per case auto e della guida autonoma avanzata, proprio perché i nostri attuali algoritmi di comprensione visiva sono limitati. È assolutamente vero che come piace a Musk sottolineare gli esseri umani nel muoversi nel mondo possono fare affidamento esclusivamente sul dominio visivo.

Ma gli occhi sono solo i sensori, mentre nel cervello c’è una peculiare capacità di estrapolare dalla mera correlazione statistica alle relazioni causali sottostanti che collegano le sue osservazioni. Gli esseri umani possono imparare anche da casi limite singolari grazie alla nostra capacità di astrarre le entità e le relazioni di ordine superiore espresse in quei casi limite.

Questo, ritiene Leetaru, è il motivo per cui la simulazione è diventata così popolare nello spazio dei veicoli senza conducente come mezzo per aumentare i pool di formazione disponibili per gli algoritmi di navigazione. Così la nostra capacità di vedere il mondo circondo circostante è uno standard aureo ma, scrive l’autore “come ogni altra cosa nel nostro mondo caotico e imprevedibile, la miriade di casi limite che rendono la guida così difficile sono rarità scarsamente rappresentate anche nei set di dati più grandi”.

Incontrare un cervo di notte che salta da dietro un albero isolato sulla strada insegna a un essere umano a stare attento non solo su quel particolare tratto di strada e non solo verso gli alberi vicino alle strade di notte, ma a cercare più da vicino tutti i tipi di forme di vita che potrebbero essere in agguato nell’ombra o ai bordi della strada davanti a te, valutando diversamente per dimensioni e pericolo per l’auto un piccolo riccio rispetto a un alce.

“Gli algoritmi di deep learning di oggi sono esclusivamente macchine di correlazione”, concludeva Leetaru. “Richiedono vaste risme di esempi per apprendere i modelli più semplicistici e non possono astrarsi al di sopra degli angusti confini di ciò che viene loro insegnato”.