Le auto a guida autonoma sono un affare per gli avvocati della Silicon Valley

In California i sistemi di guida autonoma di General Motors e Tesla fanno notizia a distanza di poche ore non per i progressi ma per le rispettive grane legali

Nel giro di poche ore dall’area di San Francisco arrivano notizie non solo, come ormai siamo abituati, di attività di sviluppo tecnologico ma anche di attività legale. General Motors e Tesla galoppano verso la completa guida autonoma, ma i loro “cavalli” hanno inciampato su due diversi ostacoli.

A San Francisco un motociclista ha intentato una causa al gruppo di Detroit per un incidente in cui è stato urtato da una Bolt, opportunamente modificata da Cruise Automation per testare i sistemi avanzati di guida autonoma di Livello SAE 4 in condizioni urbane.

Con l’aumentare delle auto-robot in circolazione era inevitabile che prima o poi una causa venisse a galla. Un episodio che va a finire in un tribunale civile sembra essere di qualche interesse per capire meglio le implicazioni che avrà sulla tecnologia messa in discussione.

Per fortuna in questo caso mancherà ogni sfumatura di dramma che l’avrebbe resa ancora più mediatica. Perché il fotografo Oscar Nilsson quando era sulla sua moto il 7 dicembre 2017 viaggiava a bassa velocità e lo stesso vale per la Bolt. La moto procedeva a 17 miglia orarie (27 km/h) e la Chevy a 12 miglia (19 km/h).

La Bolt, con un ingegnere a bordo ma i sistemi di guida a controllarla, avrebbe iniziato a cambiare corsia spostandosi alla sua sinistra, la moto ha superato la Chevrolet sulla destra e quando la Bolt ha deviato di nuovo verso destra il motociclista è caduto, riportando alcune contusioni a collo e spalla. La polizia stradale di San Francisco ha attribuito la responsabilità alla moto per aver superato sulla destra.

Il legale del fotografo, Sergei Lemberg, cerca un risarcimento per il suo cliente perché sostiene che il verbale dimostra proprio il contrario, anche perché il tecnico GM a bordo della Bolt aveva cercato di intervenire quando il computer si è spostato a destra sterzando per evitare la moto.

Quello della polizia stradale non è il solo resoconto sulla collisione del 7 dicembre: GM è tenuta a fare un rapporto alla motorizzazione della California per ogni incidente piccolo o grande che coinvolga uno dei suoi oltre 100 veicoli test e dei circa 300 tecnici a bordo.

Nel suo resoconto la casa americana ha confermato che il computer della Bolt aveva interrotto un cambio di corsia verso sinistra, ma sostiene che l’auto si stava riallineando nella corsia mentre Nilsson, che aveva seguito l’auto a cavallo delle due corsie, si sarebbe spostato al centro per poi sfiorare la Bolt e in seguito cadere.

Questo genere di sinistri stradali normalmente sarebbe trascurabile, eccetto se vede coinvolti veicoli e sistemi di guida autonoma. Perché siamo ancora in una fase in cui è importante verificare l’affidabilità di questi sistemi nelle condizioni reali, specialmente nel traffico urbano.

Un confronto legale può, ad esempio, aiutare a capire quanto siano all’altezza del compito i sensori odierni: non è ininfluente sapere se i sensori ultrasonici o il radar della Bolt hanno fornito un quadro sufficientemente esatto e rapido dell’ambiente che la circondava al momento del contatto con la moto.

Alcune agenzie di difesa dei consumatori hanno sottolineato che la trasparenza sulle eventuali pecche (o gravi difetti) dei sistemi sono essenziali per la tranquillità di chi nelle città viene a contatto con queste nuove tecnologie.

Nemmeno a farlo apposta proprio in queste ore è stato diffuso il terzo sondaggio annuale della compagnia di assicurazione AAA sulla fiducia degli americani nelle auto-robot. Rispetto al sondaggio di un anno prima la percentuale di chi ha risposto che avrebbe timore a salire su un taxi a guida autonoma è scesa: dal 78% al 63%.

Forse al relativo miglioramento della percezione del pubblico sta iniziando a contribuire anche la crescente diffusione dei sistemi ADAS, che sempre più spesso supportano la sicurezza in situazioni nelle quali i guidatori non sarebbero in grado di fare altrettanto bene e con altrettanta rapidità.

Ma la percentuale di automobilisti americani che si sente ancora poco sicura nel pensare di condividere il traffico con auto guidate permanentemente dai computer resta comunque alta: il 46%. Ci sono, in sostanza, ancora molte remore da superare da parte degli automobilisti e del pubblico in generale.

Per chi investe denaro e risorse nella tecnologia che porta alla guida autonoma svincolata dalla presenza umana, superare a pieni voti i primi ostacoli legali e i dubbi e rispondere agli interrogativi sollevati da alcuni incidenti, per quanto relativamente rari, è essenziale. Certo più importante di sbandierare i chilometraggi accumulati con successo dai loro sistemi.

Per questo è importante che arrivino risposte e chiarimenti su un altro incidente, anche questo senza vittime ma avvenuto su una freeway invece che in città e quindi a velocità più sostenuta, che ha coinvolto lunedì scorso sulla Interstate 405, presso Culver City, una Tesla Model S su cui il guidatore ha affermato che l’Autopilot era in funzione.

While working a freeway accident this morning, Engine 42 was struck by a #Tesla traveling at 65 mph. The driver reports the vehicle was on autopilot. Amazingly there were no injuries! Please stay alert while driving! #abc7eyewitness #ktla #CulverCity #distracteddriving pic.twitter.com/RgEmd43tNe

— Culver City Firefighters (@CC_Firefighters) January 22, 2018

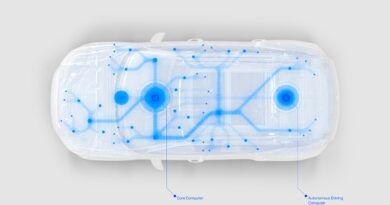

Meno sofisticato di quello montato da Cruise Automation sulle Bolt (che GM vuole trasformare presto in un servizio di robo-taxi) l’Autopilot è un sistema semi-autonomo che nella versione attuale è classificato come Livello 2 SAE. Il che significa che necessita di costante supervisione del guidatore, che in qualunque momento resta responsabile della condotta del veicolo e deve essere sempre pronto ad intervenire.

Il motivo per cui un incidente con un Autopilot ha indotto l’agenzia americana per la sicurezza stradale National Transportation Safety Board ad interessarsene è che la Model S ha urtato un camion dei pompieri, certo ben visibile, mentre era in sosta coi lampeggianti accessi sulla corsia di emergenza per un intervento su un precedente incidente.

L’impatto ha avuto conseguenze notevoli sulla Tesla, che secondo i vigili del fuoco prima della collisione stava viaggiando a 65 miglia orarie (104 km/h), prima di rallentare per l’urto ad una velocità non precisata.

Se il conducente è uscito dall’incidente senza alcuna conseguenza fisica (il che depone a favore della sicurezza passiva della Tesla) non è ancora chiaro come possa avere a lungo ignorato i molteplici avvisi di attenzione che il dispositivo lancia in caso di pericolo o comunque di situazioni che non è in grado di gestire.

Dopo un incidente fatale verificatosi ad una Model S nel 2016, la National Transportation Safety Board stabilì che la vecchia versione dell’Autopilot lasciava troppo tempo al guidatore prima di obbligarlo a riprendere il controllo. Inoltre non monitorava abbastanza la sua attenzione su traffico e ambiente circostante.

L’attuale versione dell’Autopilot sembrava fin qui in grado di monitorare in modo puntiglioso l’attenzione del guidatore. Inoltre la casa di Palo Alto si era risolta a costringere i suoi clienti a tenere le mani sul volante o a non distrarsi con segnali acustici e vibrazioni, in alcuni casi fino ad arrivare a parcheggiare l’auto a bordo strada se ignorati.

Il caso della collisione di Culver City sembra poter essere per la stessa Tesla una opportunità per verificare che anche un possibile caso limite fin qui trascurato venga inserito negli eventi che il software sarà in grado di gestire.